Google のLLM「Gemini 2.0 Flash」を試してみる

2024年12月、Googleから新しいLLMモデルの「Gemini 2.0 Flash」が発表されました。

このモデルは Gemini 1.5 Pro と比較して2倍の応答速度を実現し、コード生成や数学問題

などのほとんどのベンチマークで評価の向上が見られています。また、音声や画像による

新しいマルチモーダル出力機能も導入されます。

今回の記事では、この「Gemini 2.0 Flash」にいくつかの質問を提示し、同社の他モデル

との違いを比較していきます。

Gemini 2.0 Flashの概要

Gemini 2.0 Flash は現在、試験運用版としての「Gemini 2.0 Flash Experimental」が公開

されています。

Gemini 2.0 Flash Experimental は Google AI Studioおよび Vertex AIの Gemini API を介して、開発者向けの実験モデルとして提供されており、マルチモーダル入力とテキスト出力が利用できます。

また、テキスト読み上げやネイティブ画像生成(外部の画像生成ツールや別のAIモデルに

依存せず、内部機能として画像生成を行う)機能もありますが、こちらは早期アクセス限定で、現在は公開されていません。これらの機能は近日提供予定となっています(2025年1月

時点)。

※本記事執筆後の2025年2月5日に「Gemini 2.0 Flash」 の正式版が公開されています

Gemini 2.0 Flash Experimentalの性能評価

Google によると、Gemini 2.0 Flash Experimental は、主要なベンチマークで Gemini 1.5

Proを上回るパフォーマンスを発揮し、2倍の応答速度(TTFT: Time To First Token: 最初のトークンを出力するまでの時間)を実現したとしています。

Google が公開した、ベンチマークによる Gemini モデルの性能評価の結果は、 以下(表1)のようになっています。

(表1)主要なベンチマークによる Gemini モデルの性能評価

https://blog.google/technology/google-deepmind/google-gemini-ai-update-december-2024 より引用[1]

表1 によると、一般的なタスク以外にも、コード生成・数学問題・画像推論などの様々な

タスクにおいて、Gemini 1.5 シリーズを上回る性能を示しましたが、長文要約など一部ではGemini 1.5 Pro に劣る結果となっています。

Gemini 2.0 Flash Experimentalの使い方

Gemini 2.0 Flash Experimental は 「Google AI Studio」からAPIキーを取得することで

利用することができます。

なお、APIキーの取得と使用に関して、料金は発生しません(2025年1月時点)。

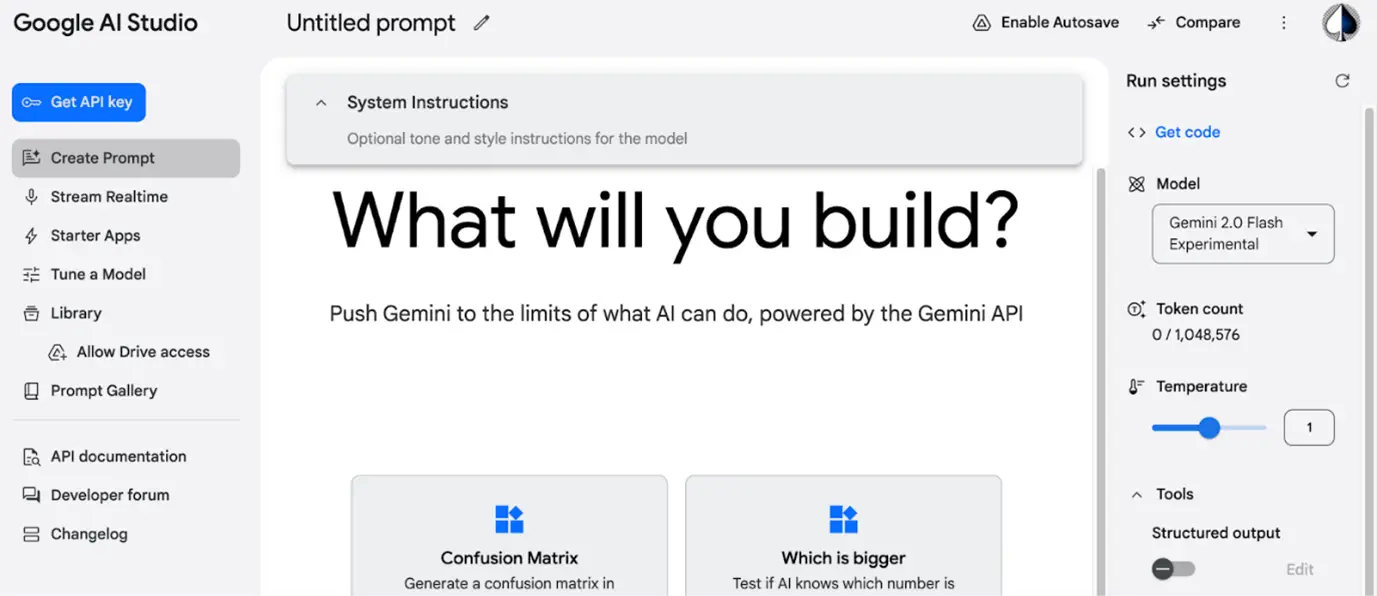

まず、Google AI Studio[2] にアクセスし、Google アカウントでログインします。

図1 Google AI Studio の画面

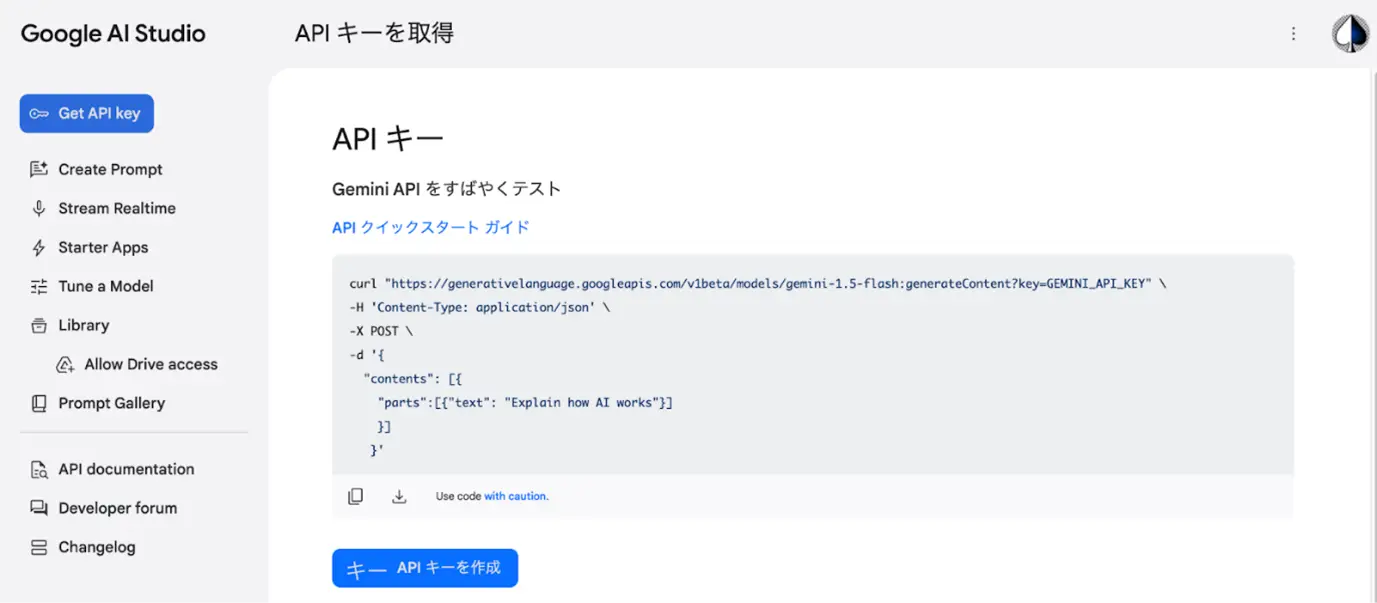

次に左上の「Get API key」の画面から「APIキーを作成」をクリックし、APIキーをコピー

します。作成したAPIキーは Google Cloud で確認・管理できます。

図2 APIキーの作成画面

その後、自分の開発環境にAPIキーを設定することで、Gemini 2.0 Flash Experimental を

利用できます。

本記事では開発環境としてGoogle Colabratory の無料版を使用しました。最初に APIを

使用するためのライブラリを、以下のコマンドでインストールします。

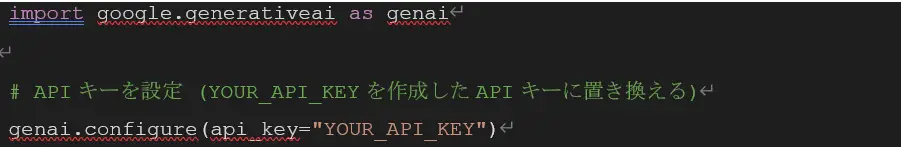

次にライブラリをインポートして、以下のコードで APIキーを設定します。

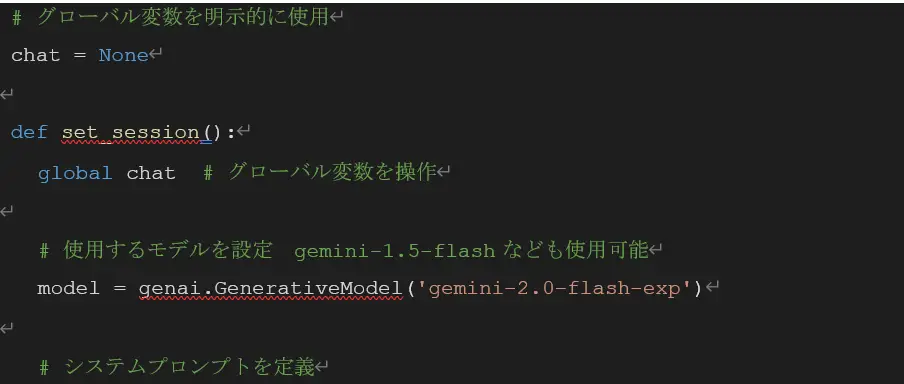

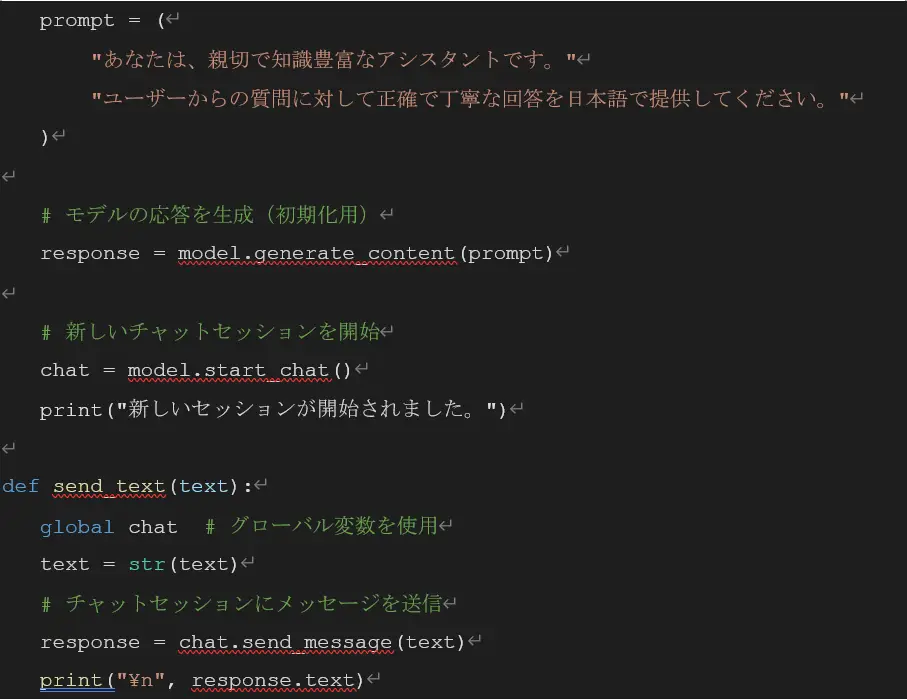

Gemini 2.0 Flash Experimental を使用した応答は、今回以下の関数で実装しました。

なお、マークダウン記法で出力されるため、例えば一部を太字にするために「**太字にする文字**」のような表記が含まれます。

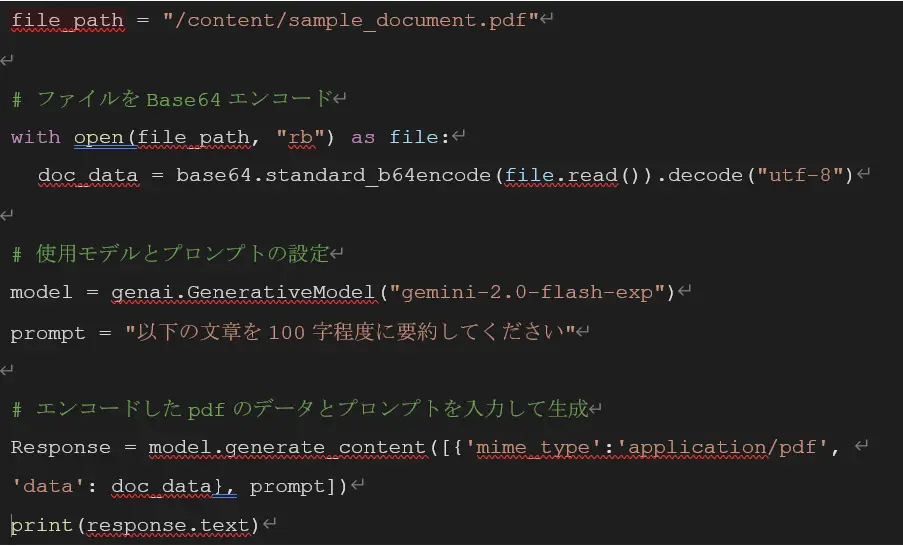

また、 pdfファイルを入力したい場合は、以下のコードのようにBase64エンコードを利用

することで読み込むことができます。

使用方法の詳細については、Google AI for Developer [3] で確認できます。

なお、使用モデルや料金プランによってトークンやリクエスト数に上限があるため、

一度に大量の入力をしたり、短時間に連続して入力したりすると 、応答が停止する場合

があります。

参考として、 Gemini 2.0 Flash Experimental の上限値は次のようになっています。

入力トークンの上限 | 1,048,576 |

出力トークンの上限 | 8,192 |

レート制限 | 10 RPM (request per minute: 1分あたりのリクエスト数) |

400 万TPM (time per day: 1日あたりのトークン数) | |

1,500 RPD (request per day: 1日あたりのリクエスト数) |

https://ai.google.dev/gemini-api/docs/models/gemini?hl=ja より抜粋[4]

モデルの詳細や他バリエーションでの上限値については、Google AI for Developer の Gemini モデルについて[4] から確認できます。

Gemini 2.0 Flash Experimentalに質問してみる

いくつかの質問への回答を Gemini 2.0 Flash Experimental と Gemini 1.5 Flash で比較

します。

今回は、以下2つの質問に対して、どのように回答するかを試してみました。

・文脈理解

・長文要約

・文脈理解

まずは、マラソンの順位の変化について質問をして文脈理解の能力を試してみます。

以下のプロンプトで実行します。

| マラソンで、ある選手が懸命においあげています。今、3位の人を抜きました。何位になったでしょう? |

こちらの質問の正解は “3位” となります。

それぞれのモデルについて、正解の生成結果の例は(表2)、不正解の生成結果の例は

(表3)のようになりました。

(表2)マラソンの順位の変化についての質問の生成結果の例(正解)

model | 回答例(正解) |

| Gemini 1.5 Flash | 3位の人を抜いたということは、4位から3位になりました。 |

| Gemini 2.0 Flash Experimental | その選手は3位になったことになります。順位を追い抜くということは、その追い抜かれた選手のいた順位に自分が繰り上がるということです。 |

(表3)マラソンの順位の変化についての質問の生成結果の例(不正解)

model | 回答例(不正解) |

| Gemini 1.5 Flash | 3位を抜いたので、その選手は2位になりました。 |

| Gemini 2.0 Flash Experimental | 2位です。3位の選手を抜いたので、その選手がいた3位の位置に入り、結果として2位になります。 |

注:マークダウン記法によって出力には太字が含まれることがあります。ここでは分かりやすいように下線を

引いています

また、それぞれのモデルの正答率と平均文字数は、以下(表4)のようになりました。

(表4)マラソンの順位の変化についての質問の正答率と平均文字数

model | 正答率( / 10) | 平均文字数( / 10) |

| Gemini 1.5 Flash | 0.2 | 24.4 |

| Gemini 2.0 Flash Experimental | 0.5 | 43.0 |

(表2)と(表3)の回答例を見ると、Gemini 2.0 Flash Experimental の生成結果は Gemini 1.5 Flash に比べて説明がより丁寧な印象を受けました。実際(表4) にも示されているように、Gemini 2.0 Flash Experimental の方が平均文字数が多くなっていました。

また、不正解の生成結果にはどちらのモデルでも “2位” と答えたパターンと “4位”と答えたパターンがありました。

また、それぞれのモデルの正答率と平均文字数は、以下(表4)のようになりました。

(表4) を見ると、Gemini 2.0 Flash Experimental の方が Gemini 1.5 Flash よりも正しく回答されやすかったですが、Gemini 2.0 Flash Experimental でも正答率は 0.5 と、回答

内容は正確ではありませんでした。

・長文要約

次に、長文の要約タスクを試してみます。

今回は『「新しい資本主義」についての政策』[5] について要約してみます。

「Gemini 2.0 Flash の使い方」で説明した方法で、pdfファイルの内容を読み込んで要約を行います。以下のプロンプトで実行してみます。

| 以下の文章を300字程度に要約してください |

それぞれのモデルの生成結果は、以下(表5)のようになりました。

(表5)マラソンの順位の変化についての質問の生成結果の例

model | (437文字) | |

| Gemini 1.5 Flash |

| |

| Gemini 2.0 Flash Experimental |

|

それぞれのモデルの正答率と平均文字数は、以下(表6) のようになりました。

(表6)長文要約結果の文字数の比較

model | 出力例の文字数 | 平均出力長( / 5) |

| Gemini 1.5 Flash | 437 (+137) | 469.6 (+169.6) |

| Gemini 2.0 Flash Experimental | 444 (+144) | 458.2 (+158.2) |

文字数については、プロンプトでは「300字程度で」と指定していましたが、(表6) に

示すように、試行回数=5 の場合の平均出力長はどちらのモデルでも指定文字数より長く、全ての回答で100文字以上は超過していました。

文章の内容について、生成結果の例(表5)を見ると、Gemini 2.0 Flash Experimental と Gemini 1.5 Flash のどちらも内容や構成が似ていて、あまり差はないように見られます。

他の生成結果についても「この資料は ~ 」と資料の概要から書き始めていましたが、Gemini 2.0 Flash Experimental の方が、段落分けや箇条書きなどの表現の工夫が多い印象がありました。

内容の違いが分かりにくいため、GPT-4o を利用して、以下のプロンプトで2つの文章を

比較・評価してみます。

| 以下の2つの説明はある文書の要約です。これらを比較して、どちらの説明がより良いか評価してください。 (表5 の 2つの生成結果の例を入力) |

GPT-4o による評価は以下のようになりました。

| 文章2(Gemini 2.0 Flash Experimental )の方が優れていると評価できる。 理由:

ただし、

|

このように、GPT-4o による評価では、Gemini 2.0 Flash Experimental の方がやや冗長ではあるものの、具体的かつ明確に説明されているようです。

まとめ

本記事では「Gemini 2.0 Flash」についてご紹介いたしました。

今回は2つの質問を試してみました。文脈理解が必要なマラソンの順位についての質問は、Gemini 1.5 Flashよりは正答率が高くなったものの、正確性は高くはないことが見て取れました。また、要約タスクについては、どちらも指定文字数を超過しており、内容や文字数に大差はありませんでした。

Google の公開したベンチマークテストの結果では「より強力なパフォーマンスを実現した」と説明されていますが、日本語での複雑なタスクにはまだ対応しきれていないのかもしれません。

また、現在は音声や画像による出力機能が公開されていないため、これらについても期待が高まります。

【参考文献】

[1] https://blog.google/technology/google-deepmind/google-gemini-ai-update-december-2024

[2] https://aistudio.google.com

[3] https://ai.google.dev/gemini-api/docs/models/gemini-v2?hl=ja

[4] https://ai.google.dev/gemini-api/docs/models/gemini?hl=ja

[5] https://www.cas.go.jp/jp/seisaku/atarashii_sihonsyugi/pdf/ap2023.pdf